Louis Rosenberg ha coniato un'etichetta che merita attenzione. Non per l'idea sottostante, che circola da tempo nei corridoi della Silicon Valley e nelle mailing list dei ricercatori, ma per il gesto stesso di nominare: AI denialism. Dare un nome a un comportamento collettivo significa renderlo visibile, e Rosenberg lo fa con la precisione di chi conosce il potere performativo delle etichette. (The rise of AI denialism)

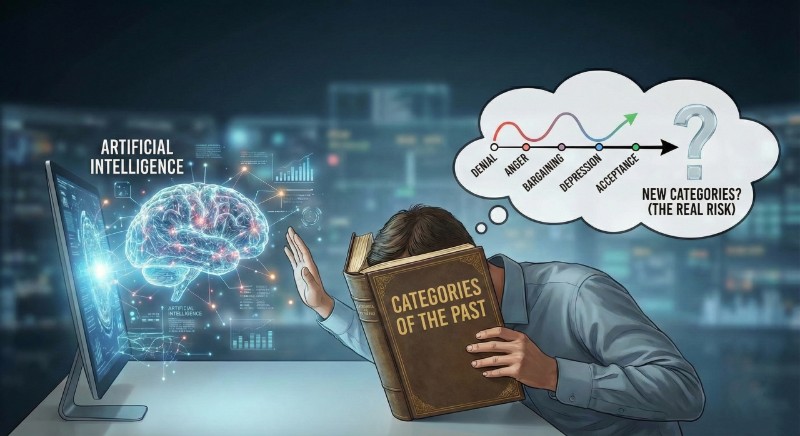

La sua tesi è semplice. Stiamo attraversando la prima fase di un'elaborazione collettiva che lui paragona alle cinque tappe di Kübler-Ross: negazione, rabbia, contrattazione, depressione, accettazione. L'oggetto della perdita non sono posti di lavoro o quote di mercato, ma qualcosa di più radicale. Rosenberg lo chiama supremazia cognitiva: il primato che l'homo sapiens ha esercitato per decine di migliaia di anni grazie a un solo vantaggio evolutivo, il cervello. Oggi quel primato vacilla.

La diagnosi è suggestiva. È anche incompleta.

Rosenberg argomenta come un CEO che difende il proprio settore, e in parte lo è: fondatore di Unanimous AI, vende soluzioni che presuppongono la disruption che annuncia. Questo non invalida l'osservazione, ma ne colora la retorica. Il modello Kübler-Ross, invocato come chiave interpretativa, funziona bene per i keynote. Funziona meno bene come strumento analitico.

Il problema è che patologizza il dissenso. Chi solleva dubbi sulla maturità degli LLM, sulla loro tendenza a confabulare, sulla fragilità delle loro capacità di ragionamento non sta necessariamente elaborando un lutto. Potrebbe descrivere limiti reali. Potrebbe fare il proprio mestiere. Trasformare denialism (rifiuto sistematico di evidenze consolidate) in denial (reazione psicologica al disagio) significa ridurre ogni scetticismo a sintomo. È una mossa retorica efficace. È anche intellettualmente pigra.

Eppure.

Eppure qualcosa di vero c'è nella diagnosi, a patto di riformularla. Le formule sono note: è solo un autocomplete evoluto, fa ancora errori banali, nel nostro dominio non funzionerà mai. Affermazioni localmente verificabili che mancano sistematicamente la scala del fenomeno. Non negazioni esplicite ma minimizzazioni chirurgiche, che assorbono ogni nuovo benchmark in una narrativa di inadeguatezza strutturale. GPT-5 vince l'International Collegiate Programming Contest con punteggio perfetto? Certo, ma non capisce davvero. Gemini 3 compie salti di capability che cinque anni fa i ricercatori collocavano nel 2033? Non ha coscienza, non può essere creativo.

Il target si sposta. Sempre.

La questione interessante non è se queste obiezioni siano false. È quale funzione svolgano.

Potremmo descriverla come inerzia ontologica: le vecchie categorie continuano a organizzare la percezione anche quando l'oggetto è cambiato. Le organizzazioni ragionano in termini di strumenti che supportano decisori umani, mentre l'AI comincia a operare come agente con gradi crescenti di autonomia. Le policy chiedono explainability totale a sistemi intrinsecamente probabilistici. I procurement pretendono output deterministici da architetture stocastiche.

Non è rifiuto della realtà. È sfasamento categoriale. È il ritardo fisiologico con cui i quadri concettuali si adeguano alle discontinuità materiali.

E la discontinuità, stavolta, non ha precedenti. La meccanizzazione ha moltiplicato la forza, l'elettrificazione ha esteso i sensi, l'informatica ha accelerato il calcolo. Nessuna di queste trasformazioni ha toccato il terreno su cui l'identità umana si era costruita: il pensiero come risorsa scarsa, come prerogativa della specie.

L'AI produce valore cognitivo a costo marginale prossimo allo zero. Questo è il fatto nuovo. Non che le macchine pensino (questione metafisica aperta), ma che producano output cognitivi indistinguibili, in molti contesti, da quelli umani. E che lo facciano con una scalabilità che nessun apparato formativo può eguagliare.

Qui emerge una domanda che Rosenberg non pone, ma che è necessaria: la distinzione tra comprensione autentica e simulazione funzionale resta operativamente rilevante quando la simulazione produce valore equivalente?

Un sistema che scrive codice competitivo a livello mondiale non ha bisogno di capire il codice nel modo in cui lo capirebbe un programmatore umano. Ha bisogno di produrlo. E lo produce. Il resto è metafisica: interessante per chi si occupa di filosofia della mente, tangenziale per chi gestisce una supply chain o una redazione o un laboratorio di ricerca.

Questo non significa che le questioni fenomenologiche siano irrilevanti. Significa che non possono funzionare come alibi per rimandare l'adattamento.

Rosenberg ha ragione su un punto cruciale: il denialism, comunque lo si voglia chiamare, non rallenta l'adozione. Rallenta la governance.

Mentre le istituzioni si interrogano su se l'AI sia davvero trasformativa, il mercato procede. L'85% delle organizzazioni, secondo Deloitte, ha aumentato gli investimenti in AI nel 2025. Il 91% prevede di aumentarli nel 2026. I lock-in si formano, le dipendenze si consolidano, le asimmetrie di competenza si amplificano. Chi arriva tardi non arriva neutrale: arriva svantaggiato, con meno potere negoziale, meno comprensione delle architetture, meno capacità di plasmare i sistemi secondo i propri bisogni.

C'è però un eccesso nell'argomentazione di Rosenberg che va segnalato. La sua retorica del pianeta che si forma dal magma tradisce un determinismo tecnologico che meriterebbe più cautela. L'AI non si sviluppa in un vuoto sociale. Si sviluppa dentro regimi normativi, culture organizzative, equilibri di potere che possono accelerarla, rallentarla, deviarla, plasmarla. Il fatto che stia accadendo velocemente non significa che stia accadendo inevitabilmente nella forma attuale.

Questa distinzione è cruciale. È lo spazio della politica.

Proviamo allora a distinguere ciò che merita critica da ciò che merita ascolto.

Il negazionismo che vale la pena smantellare non è quello di chi pone domande scomode sui limiti degli LLM. È quello di chi usa i limiti attuali come alibi per non ripensare processi, competenze, modelli di business. È la resistenza che si traveste da prudenza metodologica mentre protegge rendite cognitive consolidate. È lo scetticismo asimmetrico che scruta l'AI con lente d'ingrandimento e lascia passare le inefficienze umane come naturali.

Ma il suo opposto speculare è altrettanto problematico: l'accelerazionismo acritico che patologizza ogni cautela, che trasforma i dubbi in sintomi e le obiezioni in resistenze da superare. È la certezza escatologica di chi ha già deciso come finisce la storia e interpreta ogni dato come conferma.

Tra il non cambia nulla e il cambierà tutto domani c'è uno spazio più interessante. È lo spazio dove le discontinuità reali si intrecciano con le continuità sottovalutate. Dove i benchmark impressionanti convivono con i fallimenti imbarazzanti. Dove la capacità di produrre codice competitivo non implica la capacità di comprendere contesti.

Quello che chiamiamo AI denialism potrebbe essere, in parte, un modo maldestro di difendere questa complessità. Difendere male, certo. Con argomenti spesso deboli, con cherry-picking selettivo, con una sordità alle evidenze che merita la critica che riceve. Ma difendere qualcosa di legittimo: il diritto di non essere travolti da una narrazione che chiede fede più che analisi, che risponde alle obiezioni spostando continuamente i pali della porta.

Forse l'oggetto della resistenza è mal identificato, non solo da chi resiste ma anche da chi diagnostica la resistenza.

Non stiamo perdendo la supremazia cognitiva. Stiamo perdendo la certezza di sapere cosa sia cognizione, cosa sia intelligenza, cosa sia comprensione. Per decenni queste parole hanno funzionato come confini impliciti tra umano e artificiale. Ora i confini si spostano, si sfrangiano, rivelano la loro natura convenzionale.

Questa perdita di certezze non è uno stadio da superare. È una condizione da abitare. Richiede strumenti nuovi, non per tornare a una chiarezza perduta ma per operare nell'ambiguità che si è aperta. Richiede una disponibilità a tenere insieme valutazioni operative (questo sistema produce valore? quali rischi comporta? come governarlo?) e interrogazioni più profonde (cosa significa comprendere? cosa perdiamo se deleghiamo? cosa guadagniamo?).

Il denialism autentico non sta nel porre queste domande. Sta nel credere che le risposte siano già scritte: nel passato, per chi nega il cambiamento, o nel futuro, per chi lo celebra.